L’incapacità di poter rallentare il ritmo frenetico della quotidianità e di ragionare lentamente sulla natura dei problemi che affrontiamo porta a un’assenza sistematica di sollecitazioni cerebrali fondamentali per lo sviluppo cognitivo.

DI Pietro Zanetti 18 Febbraio 2022

Tra gli interrogativi che da alcuni millenni tormentano l’uomo e che, ancora oggi, non hanno trovato risposte del tutto soddisfacenti, nonostante gli ampi passi avanti, primeggia il quesito sulla natura e il funzionamento della mente umana. L’unica certezza della modernità, sorta insieme alla rivoluzione scientifica, sembrava essere che, nel tempo, il potenziale intellettuale umano non potesse che evolvere incontrastato. Questa concezione, però, oggi viene messa in discussione dall’ubiquità della tecnologia e dallo sviluppo delle intelligenze artificiali.

La parola “intelligenza” proviene dal latino “intelligere”, a sua volta derivato dall’unione di due particelle: inter e lègere. Letteralmente, è la capacità di saper leggere, o di distinguere la realtà attraverso i dati e le entità a disposizione nell’ambiente che ci circonda. Tuttavia, data la sua natura indefinita e disomogenea, è stato necessario completare la definizione discriminando la semplice abilità cognitiva dal pensiero soggettivo, il senso d’identità e di esistenza. Per alcuni, poi, c’era una componente conscia e consapevole che contraddistingueva l’intelletto umano dalla cognizione animale: gli antichi greci, ad esempio, definivano quest’ultimo elemento “nous”, ragione, o la capacità d’ascolto dell’essere verso sé stesso e il rapporto tra la propria interiorità ed il mondo circostante. Nelle Meditazioni metafisiche, del 1641, Cartesio teorizzò un dualismo “moderno” tra corpo e anima dividendo la natura umana in res cogitans, l’anima pensante, e res extensa, la componente meccanica, soggetta alle leggi naturali. Il come questi due poli opposti e complementari potessero comunicare rimarrà un quesito aperto per i successivi secoli.

Il sapere di sentirsi esistere e la capacità di dominio sul proprio sé d’altronde rappresentano concetti metafisici per i quali il dilemma della formulazione di una definizione di intelligenza non è ancora stato risolto. Le neuroscienze, oggi, suggeriscono che l’enorme complessità del cervello umano potrebbe essere spiegata dal funzionamento delle connessioni neurali che sembrano costituire la struttura della soggettività e del pensiero conscio. Ogni neurone – se ne contano centinaia di miliardi – presenta infatti circa diecimila contatti sinaptici con altri neuroni e la quantità di informazioni scambiate è ancora ad oggi incalcolabile. Ci si chiede quindi se sia ancora sostenibile, perlomeno da un punto di vista scientifico, parlare di anima e libero arbitrio. Su questa domanda poggia l’idea neopositivista per cui, come ogni altro organo, il cervello, e quindi la coscienza, possa essere fisicamente riproducibile e programmabile, concezione che è stata alla base della nascita del campo dell’intelligenza artificiale.

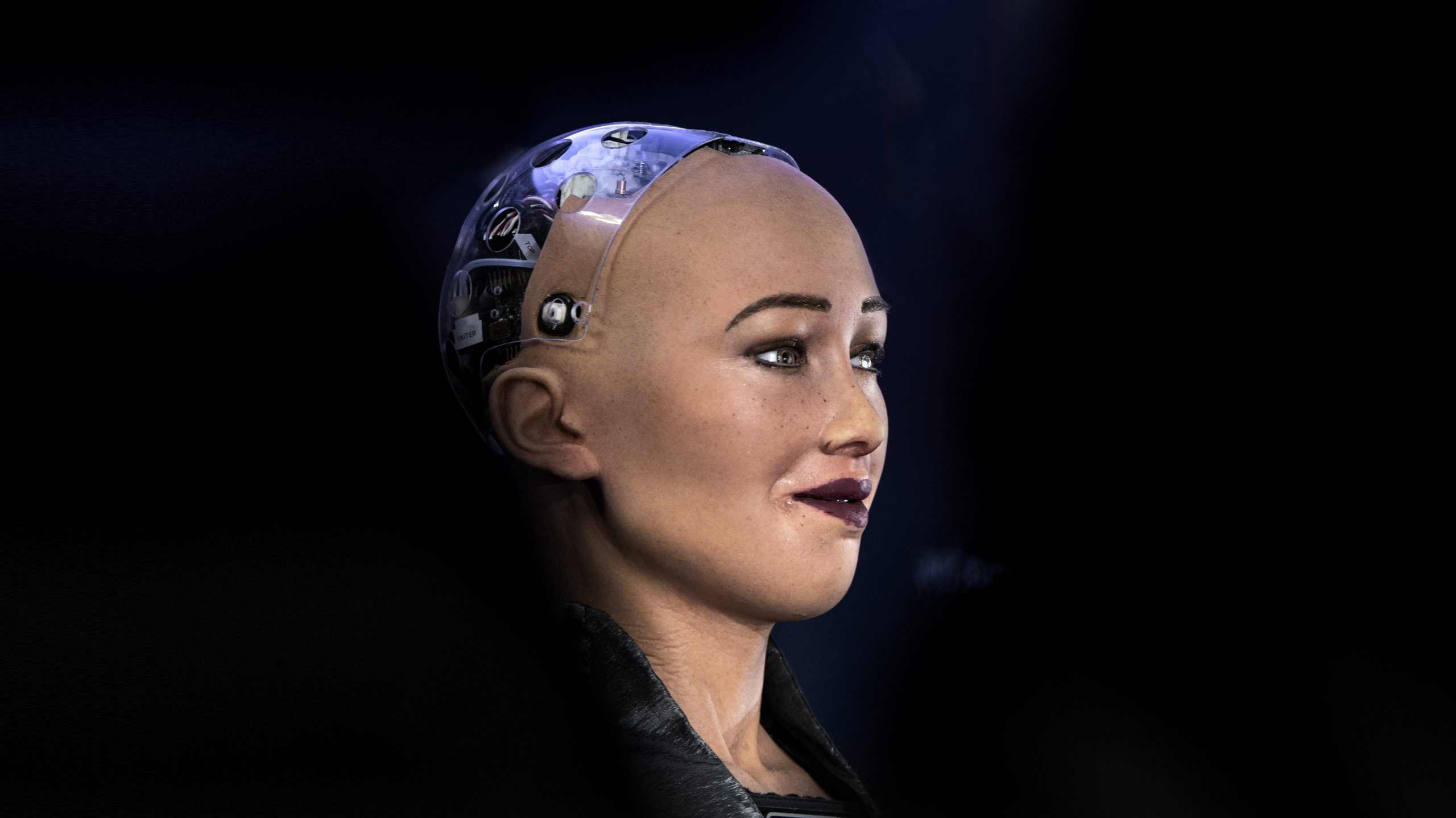

Sviluppatasi in concomitanza con l’evoluzione tecnologica statunitense del secondo dopoguerra, questa branca delle scienze computazionali si pone come obiettivo quello di interpretare il funzionamento del sistema nervoso in chiave informatica. Ciò che distingue il cosiddetto machine learning dalla semplice nozione di algoritmo o di programmazione è infatti la possibilità di apprendimento autonomo e non supervisionato da parte delle macchine. Il programmatore non ha più bisogno di impostare le funzioni e i codici utili alla risoluzione di un problema, ma viceversa è il computer, attraverso procedimenti iterativi, a trovare potenziali relazioni partendo dai soli dati iniziali. Il processo di apprendimento automatico è stato reso possibile dallo studio organico del sistema nervoso: lo schema di base delle reti neurali informatiche è infatti interamente fondato sul funzionamento dei neuroni appartenenti alle cortecce visive animali.

La quantità di calcoli gestiti in un intervallo di tempo dai computer cresce senza sosta e in un futuro non molto remoto le nuove tecnologie quantistiche permetteranno ai computer di elaborare in tre minuti ciò che una macchina tradizionale oggi elaborerebbe in diecimila anni. Alan Perilis, uno dei primi e più influenti data scientists statunitensi, già nel 1982 scrisse che “[…] un anno speso nell’ambito dell’Intelligenza Artificiale è abbastanza per farti credere in Dio”. Seppur guidato da ritmi meno sostenuti, altrettanto promettente potrebbe risultare l’avanzamento cognitivo umano. L’avvento del Rinascimento moderno, dei traguardi scientifici e della diffusione di sapere e conoscenza per molti sono indiscutibilmente dei fattori propulsivi. La tecnologia sarebbe solo uno mezzo di cui l’uomo, in totale controllo e autonomia, si servirebbe per migliorare la realtà e alimentare il progresso.

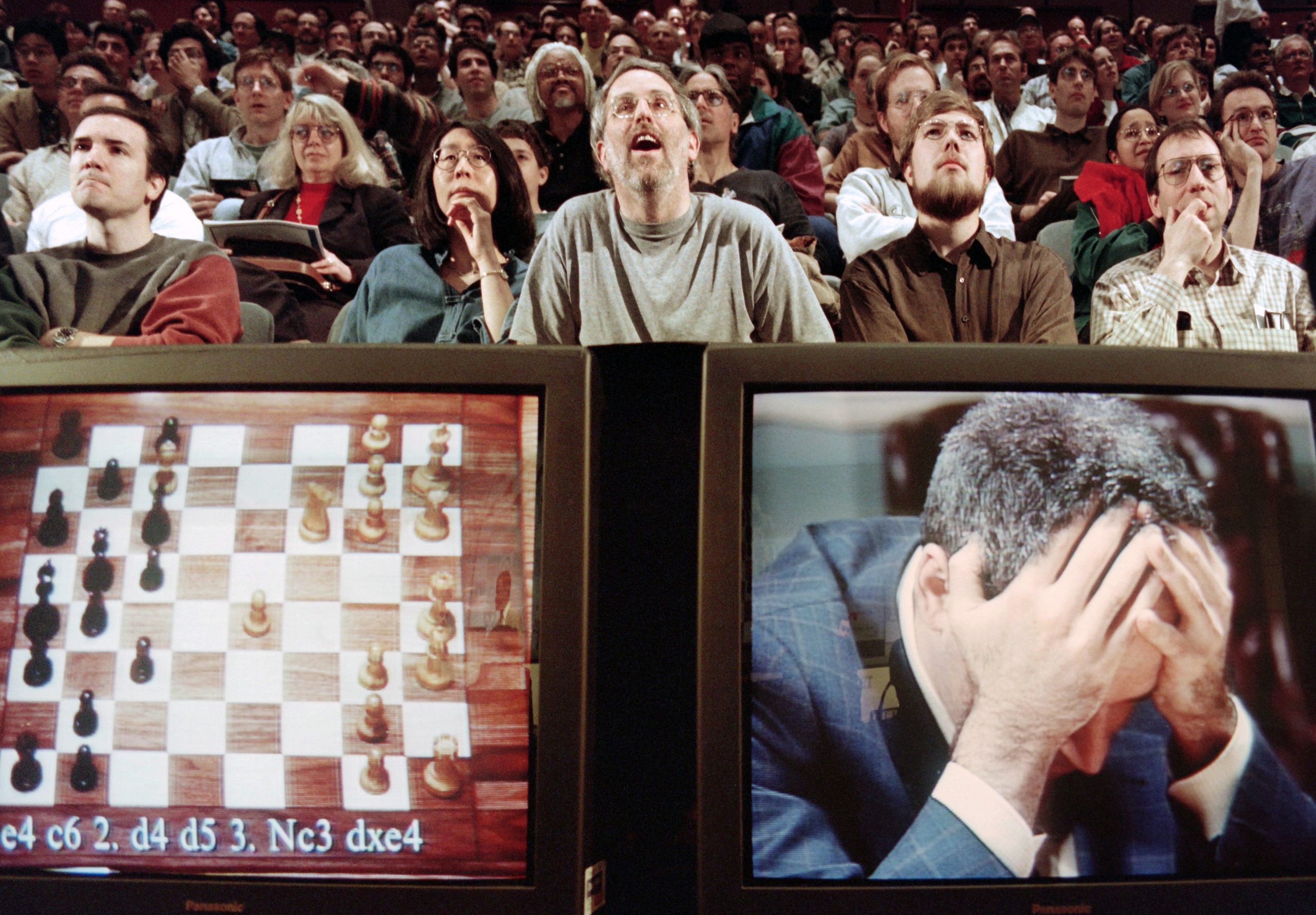

A questo proposito, nel 1987 fu pubblicato sul Psychological Bulletin uno studio destinato a diventare uno dei grattacapi scientifici più celebri nel campo della ricerca psicologica. L’autore, James Flynn, misurò l’evoluzione dei risultati di test QI in diversi Paesi a partire dal 1938 e la conclusione apparve sorprendentemente positiva: i quozienti intellettivi risultavano infatti aumentare in media di tre punti per decennio, comprendendo sia l’intelligenza cristallizzata, le conoscenze teoriche, che quella fluida, il problem solving. L’inatteso fenomeno fu battezzato “Effetto Flynn” e ha rappresentato una fonte di dibattito per i decenni a seguire. Tra i fattori responsabili erano stati identificati la crescita dei tassi di alfabetizzazione, il progresso della qualità della vita media e la diminuzione della mortalità infantile.

Tuttavia, l’ottimismo diffuso a partire dalla seconda metà del Novecento attualmente sembra essersi rivelato ingiustificato. Studi più recenti, condotti a partire dai primi anni del Duemila, dimostrerebbero infatti risultati contrastanti. Sta riscontrando sempre più validità l’ipotesi secondo cui il presunto miglioramento dell’intelletto umano stia subendo un’inversione di tendenza. In un articolo pubblicato su PNAS (Proceedings of the National Academy of Sciences of the United States of America) nel 2018, i ricercatori Bernt Bratsberg e Ole Rogeberg affermano l’invalidità dell’Effetto Flynn, concludendo che non solo questo presentasse delle inconsistenze statistiche, ma che correggendole si verificasse una diminuzione del QI intergenerazionale. Esaminando 730mila test compiuti su uomini Norvegesi dal 1970 al 2009, il quoziente intellettivo arriva a registrare perdite di sette punti per generazione a partire dagli anni Novanta. Altre recenti pubblicazioni confermano poi la diffusione del trend discendente in diversi Paesi sviluppati quali Danimarca, Gran Bretagna, Francia e Australia. Lo stesso Flynn – in uno studio del 2016 condotto su un campione di adolescenti norvegesi e britannici – scriverà che “il progresso in QI registrato nel ventesimo secolo si è indebolito”. Mentre la crescita delle capacità di calcolo dei computer odierni aumenta seguendo una curva esponenziale, l’intelligenza umana sembra essere in declino.

Tra le principali cause ipotizzate, viene citata proprio la pervasività della tecnologia e l’influenza che essa esercita nei confronti dello sviluppo dell’attenzione e della concentrazione nei bambini cresciuti nell’era digitale. La dipendenza passiva da dispositivi, programmi e servizi che ci permettono di risolvere qualsiasi problema decisionale o mnemonico in poche frazioni di secondo confligge non solo con lo sviluppo dell’intelligenza razionale, ma anche di quella emozionale. La pioggia informatica di notifiche, messaggi, immagini, informazioni e suoni a cui siamo costantemente sottoposti tende infatti a innescare sensazioni di stress che portano a un generale impoverimento delle capacità di giudizio e di decisione. All’interno di questo dedalo informatico l’unico vincitore è la tecnologia, a scapito di una sempre maggiore atrofia intellettuale dovuta all’eliminazione della fatica del pensiero.

L’incapacità di poter rallentare il ritmo frenetico della quotidianità e di ragionare lentamente sulla natura dei problemi che affrontiamo porta a un’assenza sistematica di sollecitazioni cerebrali fondamentali per lo sviluppo cognitivo. A conferma dell’elevato grado di elasticità del cervello umano, un celebre studio dell’University College of London rivela che nei tassisti londinesi, privi di mappe o navigatori GPS a loro disposizione, l’ippocampo è maggiormente sviluppato rispetto alla media. Quest’area di corteccia cerebrale è la principale responsabile nella gestione della memoria, dell’apprendimento e dello stress. Ogni qualvolta decidiamo di delegare un compito intellettualmente impegnativo a una delle svariate appendici informatiche che dominano la nostra vita, stiamo rinunciando a uno stimolo attivo nelle aree della memoria, del controllo emozionale e dell’elaborazione del pensiero astratto.

Sarebbe quindi necessario ripensare alcuni dei dogmi della contemporaneità, come il culto della velocità, della produttività e del multitasking. Quest’ultima pratica, ormai diffusa in tutte le fasce d’età, viene in particolar modo esaltata troppo spesso come un’invidiabile capacità di lavoro simultaneo e polifunzionale, ma se per alcune conformazioni cerebrali è davvero così, la realtà è che per la maggior parte degli individui, come dimostrano numerosi studi scientifici, il multitasking non è altro che un eufemismo usato per indicare un fenomeno i cui molteplici compiti vengono svolti in contemporanea, con uno sforzo intellettuale notevole e con conseguenti cali di efficienza. Nel momento in cui frammentiamo l’attenzione dirigendola verso più obiettivi contemporaneamente, infatti, si innesca la produzione di cortisolo (l’ormone dello stress) e di adrenalina: non solo non stiamo realmente concentrando le capacità del nostro intelletto, ma avviene una compromissione generale della lucidità di pensiero.

Se è vero che la tecnologia rappresenta una risorsa fondamentale per lo sviluppo delle società umane e per la diffusione universale di benessere ed educazione, è altrettanto cruciale una visione critica e attiva nei confronti degli effetti che genera. Il rapporto uomo-macchina è fondato su un fragile equilibrio tra utilizzo etico e consapevole e il rischio è che una cieca fiducia nei confronti della tecnica sfoci in un progresso fine a sé stesso, che vede l’uomo diventare strumento dell’oggetto stesso. Attraverso l’abuso di sussidi tecnologici stiamo a tutti gli effetti accettando una riduzione della nostra potenza di pensiero, che non sembra riversarsi su altro e semplicemente smette di essere esercitata. L’intelletto umano sembra sempre più proiettato verso un unico fine: lo studio e la progettazione di versioni informatiche e autonome di se stesso e questo – date le sue conseguenze – forse più che esaltarci dovrebbe allarmarci, o quantomeno farci riflettere più approfonditamente sul tema. Nel patto faustiano del terzo millennio, i benefici apparenti ottenuti dall’accesso al progresso sottendono un costo umano: questa volta, vendendo l’anima, stiamo anche cedendo la nostra intelligenza, e forse è ancora più grave.

Fonte: https://thevision.com/attualita/tecnologia-quoziente-intellettivo/